2016/12/15

第118回 大学入学希望者学力評価テストに対する懸念と検討すべき課題

研究員 野澤 雄樹

高大接続システム改革会議の「最終報告」(高大接続システム改革会議,2016)が平成28年3月31日付で公表されました「最終報告」は高等学校教育改革,大学教育改革,大学入学者選抜改革で構成され,各テーマについてさまざまな提言がなされています。その中で特に影響が大きい提言の1つは,大学入学者選抜改革に関連して,現行の大学入試センター試験を廃止し,「大学入学希望者学力評価テスト(仮称)」(以下「新テスト」)を導入すること,そしてそのテストで記述式の問題を出題するということだと思います。新テストの細かい制度設計はこれから本格化していくことになりますが,本オピニオンでは,新テストについて現時点で懸念されること,今後検討しなければならないことなどを,教育測定学的な観点から挙げてみます。

新テストで懸念されること

「最終報告」では,学力の3要素(「知識・技能」「思考力・判断力・表現力」「主体性・多様性・協働性」)がこれからの社会において極めて重要であるという認識に基づいて,それらの育成を強化するためのさまざまな改革が提言されています。大学入学者選抜改革についても,入学者選抜の基準を学力の3要素を重視したものに変えることで,「高等学校における指導の在り方の本質的な改善を促し」,「大学教育の質的転換を大きく加速」させることが「基本的な考え方」の中で述べられています(「最終報告」41ページ)。新テストの導入および記述式問題の出題は,学力の3要素のうちの「思考力・判断力・表現力」を共通テストで問うことで,従来の「知識・技能」に重点を置いた教育からの転換を目指したものであると言えます。大学入試が持つ役割にはさまざまなものがありますが,「最終報告」では,学習の動機づけとしての役割が強く意識されていると考えられます。

「最終報告」を読んで懸念することは,学力の3要素の育成が重視される一方で,大学入試が持つ「受験者の資質・能力について客観的な情報を提供する」という役割に関する記述が少ないことです。大学がある受験者の合否を正しく決めるためには,その受験者が大学の授業についていけるだけの基礎学力を身に付けているか判断する必要があります。このような判断の基になる信頼できる情報を提供することが,大学入試の本来の役割であるはずです。しかし「最終報告」では,新テストにこの役割がどの程度求められるのか,明確には述べられていません。もし「知識・技能」よりも「思考力・判断力・表現力」のほうが大学での学業成績と強く関連しているのであれば,後者を重視した問題を多く取り入れた新テストのほうが,受験者の資質・能力についてより適切な情報を提供できるかもしれません。ただしそれは,新テストが「思考力・判断力・表現力」を正確に測定していることが前提になります。実際には,次節で述べるように,記述式の問題を使用したテストは測定精度(教育測定学の専門用語でテストの「信頼性」と言います)が低くなりがちであることが知られています。そのため,適切な設計をしないと,新テストの導入によって大学入試本来の役割が十分に果たせなくなってしまう可能性があります。

記述式の問題で構成されるテストの信頼性

一般に記述式の問題は多肢選択式の問題に比べて1問あたりの解答時間が長いので,限られた試験時間内でたくさん出題することはできません。また,記述式の問題を多く出題すると,それに伴って採点の負担も増えるので,コストの面からも問題数が制限されることになります。1問あたりの信頼性は記述式の問題のほうが多肢選択式の問題よりも高い場合が多いですが,出題できる問題数が少なければ,テスト全体としての信頼性は低くなってしまいます。

記述式の問題で構成されるテストの信頼性について考えるために,ベネッセ教育総合研究所で開発中の論述力テストを例として用います。このテストでは,問題ごとに主張すべき内容と複数の資料が与えられます。受験者は資料を読んで主張の根拠となる情報を抽出し,それらを統合して論理的な文章を書くことが求められます。1問あたりの解答時間は約30分程度で,字数制限はないものの,600字以内で十分に解答できる内容になっています。採点者は複数の観点で答案を評価し,その結果は換算ルールに従って1~5点に変換されます。

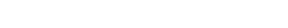

このテストの試作問題を205人の学生モニターに実施し,4人の採点者に採点してもらったデータを一般化可能性理論(Brennan, 2001)と呼ばれる手法で分析しました。その結果に基づき,問題数と採点者数を変えたときにテストの信頼性がどのように変化するかシミュレートした結果が図1になります。ここでは,信頼性の指標として一般化可能性係数を使っています。一般化可能性係数は0から1までの値を取り,0に近いほど信頼性が低く,1に近いほど信頼性が高いことを表します。テストの使用目的によって必要な信頼性は異なりますが,ここでは一般化可能性係数が0.75以上であれば信頼性が高いと考えることにします。

図1 問題数および採点者数を変えたときの一般化可能性係数の変化

注1 首都圏の大学に通う学生モニター205人に対し,4つの記述式問題をコンピューター上で出題した。採点を請け負う業者を通じて4人の採点者を集め,3時間程度の事前トレーニングを行った後,それぞれの採点者がすべての受験者のすべての問題に対する解答を採点するように依頼した。このデータ収集デザインは,一般化可能性理論の文脈でp×t×rデザインと呼ばれるものである。

注2 テストは2013年7~8月,採点は2015年2~3月に行われた。

注3 一般化可能性係数は,問題ごとに異なる採点者を割り当てる状況を想定して計算した(p×(R:T)デザイン)。例えば,採点者が2人の条件では,採点者AとBが問題1の採点を行い,採点者CとDが問題2の採点を行うような状況を想定している。

注2 テストは2013年7~8月,採点は2015年2~3月に行われた。

注3 一般化可能性係数は,問題ごとに異なる採点者を割り当てる状況を想定して計算した(p×(R:T)デザイン)。例えば,採点者が2人の条件では,採点者AとBが問題1の採点を行い,採点者CとDが問題2の採点を行うような状況を想定している。

図1に示されているように,一般化可能性係数は問題数および採点者数が増えるにつれて高くなります。しかし,採点者を1人から2人に増やした場合に比べると,2人から3人,3人から4人に増やしたときの一般化可能性係数の増加量は小さいことがわかります。このことは,採点者は2人,多くても3人いれば十分であることを示しています。一方,問題数が少ないときの一般化可能性係数は0.75を大きく下回っており,採点者が2人の場合で考えると,6問出題してようやく0.75に近くなることがわかります。そうすると,1問あたりの解答時間が約30分ですから,約3時間の試験時間が必要になります。

このような結果になるのは,受験者と問題の交互作用(問題による出来・不出来の差)が想像以上に大きいためです。実際に,ある受験者が異なる問題に対して解答した内容を比較してみると,同じ受験者が書いたとは思えないほど解答の質に差があることも珍しくありません。記述式の問題は1つの解答から読み取れることが多いので,それだけを見て受験者の能力がわかった気になってしまいますが,その判断は思ったほど正しいものではありません。たまたま出題された問題と相性が良かったので良い解答が書けたということが大いにあり得ます。

文部科学省が平成28年8月31日付で公表した「高大接続改革の進捗状況について」(文部科学省,2016)を見ると,記述式の問題については採点の効率や体制が優先的に検討されているようです。限られた期間に採点できるのかということは,そもそもテストが実現できるかという根幹に関わる部分なので,先に議論されるのは当然のことです。しかし,上の例で示したように,受験者と問題の交互作用に起因する得点の変動のほうが,採点のぶれによる得点の変動よりも結果に大きな影響を与える可能性があります。そのため,どのように受験者と問題の交互作用をコントロールするのかについても,今後しっかりと検討する必要があると思います。

テストの構成と測定する能力

前節で挙げた例は,記述式の問題のみでテストを構成しようとした場合の話です。新テストで記述式の問題が出題されるのは当面は国語と数学で,マークシート式の問題と記述式の問題が併用されることになります。そのため,マークシート式の問題を十分な数出題すれば,記述式の問題の数が少なくても,テスト全体としての信頼性を高くすることは可能です。ただ,この方法で信頼性を高くしようとする場合,記述式部分の配点を小さくする必要があります。信頼性が低い記述式部分に大きな配点をかけてしまうと,テスト全体の信頼性も低くなってしまうからです。一方で,記述式部分の配点を小さくしてしまうと,新テストが測定したい「思考力・判断力・表現力」が十分に得点に反映されなくなる可能性があります。そのため,配点を決める際には,テストが測定しようとしている能力の定義,マークシート式部分で測定している能力と記述式部分で測定している能力の関係性,各部分の信頼性などを考慮して,慎重に決める必要があります(野澤・伊藤・須永・堂下・村田,2016)。

ここで注意しないといけないのは,新テストの結果をマークシート式部分の得点と記述式部分の得点に分けて提示し,各大学にその利用を任せてしまうことの危険性です。もしある大学が記述式部分の結果を重視し,マークシート式部分の得点と記述式部分の得点を,例えば1対4で重みを付けて足し合わせるようなことをしてしまうと,その大学は信頼性の低い得点に基づいて合否判定をしていることになりかねません。このような問題を避けるためには,各大学がどのように結果を利用しているのかについて,新テストの実施主体がきちんとモニタリングする必要があります。また,各大学も,テストの信頼性などの基本的な情報を把握した上で,新テストの結果と入学者の成績を追跡調査するなど,入試機能を高めるためのさまざまな研究を行う必要が出てくると思います。

おわりに

「高大接続改革の進捗状況について」(文部科学省,2016)によると,平成29年度に新テストの事前プレテストが計画されているようです。この結果を通じて,新テストについて多くのことがわかってくると思います。事前プレテストの結果は,多くの専門家・研究者が検討に参加できるように,なるべく広く公開されることが望まれます。新テストの導入に伴う課題にはさまざまなものがあり,ここで挙げたのは一部に過ぎません。多くの課題は一朝一夕に解決できるものではなく,多くの専門家・研究者の知見を統合する必要があります。ベネッセ教育総合研究所としては,教育測定学的な研究を積極的に推進・発信していくことで,大学入試改革の動きに貢献していきたいと考えています。

■引用文献

Brennan, R. L. (2001). Generalizability theory. New York: Springer-Verlag.

高大接続システム改革会議 (2016). 高大接続システム改革会議「最終報告」

文部科学省 Retrieved from

http://www.mext.go.jp/b_menu/shingi/chousa/shougai/033/toushin/1369233.htm (2016年11月1日)

文部科学省 (2016). 高大接続改革の進捗状況について 文部科学省 Retrieved from(2016年11月21日)

野澤 雄樹・伊藤 素江・須永 正巳・堂下 雄輝・村田 維沙 (2016). 論述力を測定する混合フォーマットテスト開発の試み 日本テスト学会第14回大会発表抄録集,52-55.

Brennan, R. L. (2001). Generalizability theory. New York: Springer-Verlag.

高大接続システム改革会議 (2016). 高大接続システム改革会議「最終報告」

文部科学省 Retrieved from

http://www.mext.go.jp/b_menu/shingi/chousa/shougai/033/toushin/1369233.htm (2016年11月1日)

文部科学省 (2016). 高大接続改革の進捗状況について 文部科学省 Retrieved from(2016年11月21日)

野澤 雄樹・伊藤 素江・須永 正巳・堂下 雄輝・村田 維沙 (2016). 論述力を測定する混合フォーマットテスト開発の試み 日本テスト学会第14回大会発表抄録集,52-55.

著者プロフィール

野澤 雄樹

ベネッセ教育総合研究所 アセスメント研究開発室 研究員

ベネッセ教育総合研究所 アセスメント研究開発室 研究員

アイオワ大学大学院教育学研究科博士課程修了,Ph.D.(教育測定学),ACT, Inc.研究員を経て,2012年ベネッセコーポレーション入社。2014年よりベネッセ教育総合研究所研究員。

主な研究テーマは,テスト理論,論述テストの開発,適応型テストの開発など。

主な研究テーマは,テスト理論,論述テストの開発,適応型テストの開発など。